Welcome to shenzhenjiahua

咨询热线:15012962335

咨询热线:15012962335

《CEACENT》搭建存储阵列和FC SAN存储网络

发布时间:2019-04-25

浏览次数:3114次

目前主流的存储方式主要有3种:DAS(直接存储)、NAS(网络附加存储)、SAN。DAS在PC机及早期的服务器中应用较多。在该方式中,数据共享及存储扩展受到严重限制,因此这种存储方式在目前来说已不再是主流。NAS采用独立于服务器,单独为网络数据存储而开发的-种文件服务器来存储设备,自形成-个网络。为了更好地满足应用在容量、性能、数据安全、数据共享等方面对存储提出的要求,必须采用网络化的存储体系。SAN不同于NAS,它不是把所有的存储设备集中安装在-个专门的NAS服务器中,而是将这些设备单独通过光纤交换机连接起来,形成-个光纤通道的存储子网,然后再与局域网相连。

1 存储阵列部署

对大多数企业而言,存储厂商提供的中端存储设备(即双控制器存储阵列,比如EMC的VNX)是可以满足所有需求的,每个控制器上配置8个8G的光纤端口即可。磁盘的数量根据数据量确定即可,如果是做共享的存储资源池,只要使用EMC的默认FAST VP的SSD、SAS、NL SAS的磁盘比例即可,RAID也就使用FAST VP的默认设置即可。也许有人会想按照业务和技术属性(Winodws/Linux/AIX,Oracle/SQLServer/DB2/MySQL/Sybase,VMware,NAS)去分析IO,然后确定RAID方案,但是负责任的说,当做共享资源池时,那些分析都没用,分析到最后,就会发现还是都RAID5吧。这个部分事实上不需要太多的工作,存储供应商会把存储本身的连线都处理好,需要规划的仅是如何做RAID和资源池,建议就告诉他们:要一对儿一模一样的存储阵列,每台上用FAST VP,默认设置就行,两台之间做MV,再加上一对儿一模一样的光纤交换机(每台上的端口数按照预计的客户主机数量+8)。

SAN是通过 - 个单独的,通常是基于光纤通道的SAN网络把存储设备以及服务器相连,如此,当有海量数据的存取需求时,数据完全可以通过SAN网络在相关服务器和后台的存储设备之间高速传输,对于LAN的带宽占用几乎为零,而且服务器可以访问SAN上的任何 - 个存储设备,提高了数据的可用性在对性能和可靠性要求较高的场合,采用先进的SAN数据存储网络,可以使数据的存储,备份等活动独立于原先的局域网之外,从而将减轻LAN的负载,保证原有网络应用的顺畅进行;同时SAN网采用光纤传输通道,可以得到高速的数据传输率.SAN存储网络系统结构框图如图1所示。

2 光纤网络连接

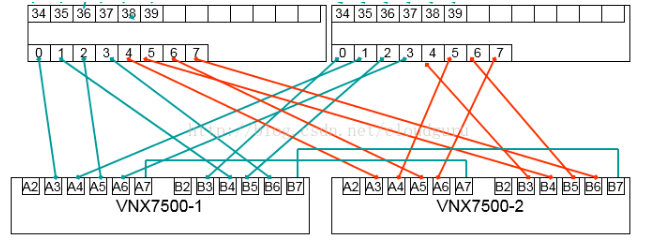

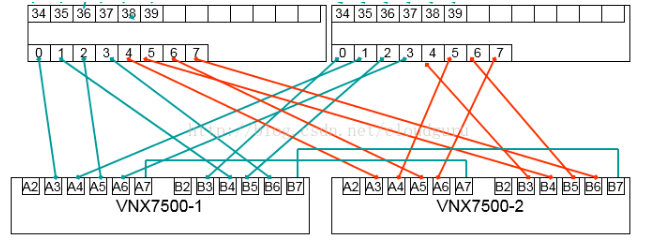

光纤网络的连接是需要确定的问题,典型的也是适用于大多数场景的连接拓扑如下:

两台光纤交换机的0-7口保留给存储阵列,0-3口给存储1,4-7口给存储2,每台存储的控制器A和控制器B的端口保留前三个,最后一个用于MirrorView直连。按照上图举例,如果一台客户主机有两块光纤卡,分别连接到了交换机1的39口和交换机2的39口,则可交换机配置中配置(39,0),(39,1),(39,4),(39,5)两个zone,最终这台客户主机将连接存储1的A3、B4、A4、B3四个端口和存储2的A3、B4、A4、B3四个端口。当在存储阵列上,配置好主机和storage group后,在客户主机上可识别到每台存储各4条链路,可使用PowerPath或OS自带链路聚合软件聚合成一个设备使用。

存储阵列可通过HBA光纤网卡来连接交换机;下面以CEACENT Emulex LPE16002 16GB双口HBA光纤网卡 为例 , 放置在存储服务器上,通过特定的光纤线来进行信息传输,达到交换机读写磁盘信息的功能,因LEP16002 HBA卡的的稳定性和传输速度能达到16GB双口;读写功能完全不逊色于内置存储阵列,还大大的降低了CPU的负荷及极大提高了其扩展性。

3 客户主机配置

共享资源池管理员最常做的就是添加新的客户主机了,对于主机的操作包括安装HBA卡驱动(linux不用)、主机兼容性测试(其实做不做都行)、HostAgent安装(已保证阵列能识别主机信息)、PowerPath安装(汇聚4条链路成一条伪链路)。这些操作都是些标准步骤,营养不大,这里不凑篇幅,主要写两个注意事项:

设置磁盘起始偏移量

在OS进行磁盘初始化时,默认的偏移量是有文件系统决定了,通常不会是整个block,这会导致IO骑着block的边界进行,会损失一点儿点儿性能(~2%~3%),所以可以指定下磁盘偏移量:

在OS进行磁盘初始化时,默认的偏移量是有文件系统决定了,通常不会是整个block,这会导致IO骑着block的边界进行,会损失一点儿点儿性能(~2%~3%),所以可以指定下磁盘偏移量:

Windows

Linux

lvm与powerpath的配置问题

由于第2部分中介绍的连接方式会在客户主机上为同一块磁盘产生5条链路(包括4条物理链路和1条伪链路),我们想使用的是其中的伪链路,如果直接使用Linux文件系统,则直接选择伪设备即可,可是lvm无法识别这些设备的关系,会当成5个设备来处理,而且会随机的选择使用哪个设备。因此需要编辑/etc/lvm/lvm.conf,用过滤器过滤掉4个物理设备,然后重启OS,在lvm.conf里找到如下行:

filter = [ "a/.*/" ] 将其注释掉,根据fdisk -l命令的输出,添加另一行filter,只准许本地磁盘设备和伪设备,拒绝其他所有设备,例如:

filter = ["a|/dev/cciss/c0d0|", "a|/dev/emcpowera|", "r/.*/"]

资料来源于:博客园 cloudguru

1 存储阵列部署

对大多数企业而言,存储厂商提供的中端存储设备(即双控制器存储阵列,比如EMC的VNX)是可以满足所有需求的,每个控制器上配置8个8G的光纤端口即可。磁盘的数量根据数据量确定即可,如果是做共享的存储资源池,只要使用EMC的默认FAST VP的SSD、SAS、NL SAS的磁盘比例即可,RAID也就使用FAST VP的默认设置即可。也许有人会想按照业务和技术属性(Winodws/Linux/AIX,Oracle/SQLServer/DB2/MySQL/Sybase,VMware,NAS)去分析IO,然后确定RAID方案,但是负责任的说,当做共享资源池时,那些分析都没用,分析到最后,就会发现还是都RAID5吧。这个部分事实上不需要太多的工作,存储供应商会把存储本身的连线都处理好,需要规划的仅是如何做RAID和资源池,建议就告诉他们:要一对儿一模一样的存储阵列,每台上用FAST VP,默认设置就行,两台之间做MV,再加上一对儿一模一样的光纤交换机(每台上的端口数按照预计的客户主机数量+8)。

SAN是通过 - 个单独的,通常是基于光纤通道的SAN网络把存储设备以及服务器相连,如此,当有海量数据的存取需求时,数据完全可以通过SAN网络在相关服务器和后台的存储设备之间高速传输,对于LAN的带宽占用几乎为零,而且服务器可以访问SAN上的任何 - 个存储设备,提高了数据的可用性在对性能和可靠性要求较高的场合,采用先进的SAN数据存储网络,可以使数据的存储,备份等活动独立于原先的局域网之外,从而将减轻LAN的负载,保证原有网络应用的顺畅进行;同时SAN网采用光纤传输通道,可以得到高速的数据传输率.SAN存储网络系统结构框图如图1所示。

2 光纤网络连接

光纤网络的连接是需要确定的问题,典型的也是适用于大多数场景的连接拓扑如下:

两台光纤交换机的0-7口保留给存储阵列,0-3口给存储1,4-7口给存储2,每台存储的控制器A和控制器B的端口保留前三个,最后一个用于MirrorView直连。按照上图举例,如果一台客户主机有两块光纤卡,分别连接到了交换机1的39口和交换机2的39口,则可交换机配置中配置(39,0),(39,1),(39,4),(39,5)两个zone,最终这台客户主机将连接存储1的A3、B4、A4、B3四个端口和存储2的A3、B4、A4、B3四个端口。当在存储阵列上,配置好主机和storage group后,在客户主机上可识别到每台存储各4条链路,可使用PowerPath或OS自带链路聚合软件聚合成一个设备使用。

存储阵列可通过HBA光纤网卡来连接交换机;下面以CEACENT Emulex LPE16002 16GB双口HBA光纤网卡 为例 , 放置在存储服务器上,通过特定的光纤线来进行信息传输,达到交换机读写磁盘信息的功能,因LEP16002 HBA卡的的稳定性和传输速度能达到16GB双口;读写功能完全不逊色于内置存储阵列,还大大的降低了CPU的负荷及极大提高了其扩展性。

想了解更多存储产品需要合作与咨询搭建方案请联系官网上的在线客服,嘉华众力自2000年成立以来一直在网络存储、传输这方面积累、沉淀;经过多年发展与全新的品牌定位,( CEACENT )嘉华众力品牌已成为国内外极具实力的数据通讯产品及方案提供商。,请关注嘉华众力官网:www.unicaca.com

共享资源池管理员最常做的就是添加新的客户主机了,对于主机的操作包括安装HBA卡驱动(linux不用)、主机兼容性测试(其实做不做都行)、HostAgent安装(已保证阵列能识别主机信息)、PowerPath安装(汇聚4条链路成一条伪链路)。这些操作都是些标准步骤,营养不大,这里不凑篇幅,主要写两个注意事项:

设置磁盘起始偏移量

在OS进行磁盘初始化时,默认的偏移量是有文件系统决定了,通常不会是整个block,这会导致IO骑着block的边界进行,会损失一点儿点儿性能(~2%~3%),所以可以指定下磁盘偏移量:

在OS进行磁盘初始化时,默认的偏移量是有文件系统决定了,通常不会是整个block,这会导致IO骑着block的边界进行,会损失一点儿点儿性能(~2%~3%),所以可以指定下磁盘偏移量:

Windows

Linux

lvm与powerpath的配置问题

由于第2部分中介绍的连接方式会在客户主机上为同一块磁盘产生5条链路(包括4条物理链路和1条伪链路),我们想使用的是其中的伪链路,如果直接使用Linux文件系统,则直接选择伪设备即可,可是lvm无法识别这些设备的关系,会当成5个设备来处理,而且会随机的选择使用哪个设备。因此需要编辑/etc/lvm/lvm.conf,用过滤器过滤掉4个物理设备,然后重启OS,在lvm.conf里找到如下行:

filter = [ "a/.*/" ] 将其注释掉,根据fdisk -l命令的输出,添加另一行filter,只准许本地磁盘设备和伪设备,拒绝其他所有设备,例如:

filter = ["a|/dev/cciss/c0d0|", "a|/dev/emcpowera|", "r/.*/"]

资料来源于:博客园 cloudguru

上一篇:服务器网卡的特征

公司新闻

公司新闻 产品快讯

产品快讯 研发快讯

研发快讯